Die neue Hexenprobe: Warum KI-Detektoren das mittelalterliche Ordal wiederbeleben

Scrolle durch Threads und stoße auf einen dieser Beiträge, die sofort zur Spaltung führen. Jemand hat einen Text gepostet und fragt: «Ist das von einer KI?» Die Kommentare explodieren. Die eine Fraktion schreit: «Natürlich KI! Siehst du nicht diese generische Formulierung?» Die andere Fraktion kontert: «Das könnte auch ein Mensch geschrieben haben, der einfach ordentlich formuliert.» Dazwischen die Verzweifelten, die nach einer eindeutigen Lösung suchen. «Gibt es nicht ein Tool, das das zuverlässig erkennt?»

Die Sehnsucht ist greifbar. Ein Knopf. Ein Scan. Ein eindeutiges Ergebnis: Ja oder Nein. Mensch oder Maschine. Authentisch oder Fake. Die Diskussion läuft immer gleich ab. Jemand verlinkt GPTZero, jemand schwört auf Winston AI, ein Dritter warnt vor Falsch-Positiv-Raten. Und mittendrin steht die Frage, die niemand wirklich beantworten kann: Funktioniert das überhaupt?

Ich habe mich gefragt, warum wir uns so verzweifelt an diese Tools klammern, obwohl die Beweislage zeigt, dass sie ungefähr so zuverlässig sind wie mittelalterliche Hexenproben.

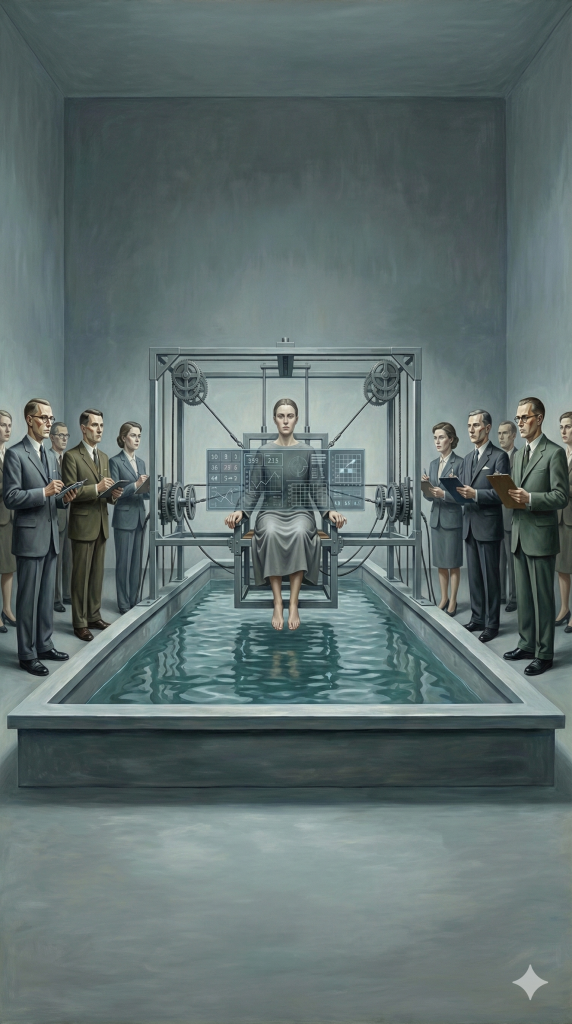

Die Wasserprobe der digitalen Moderne

Im Mittelalter gab es die Wasserprobe: Man warf die verdächtige Person ins Wasser. Ging sie unter und ertrank, war sie unschuldig. Schwamm sie, war sie eine Hexe und wurde verbrannt. Eine wunderbare Logik, nicht wahr? Heute werfen wir Texte in KI-Detektoren. Schlägt das Tool an, bist du schuldig. Schlägt es nicht an, hattest du Glück. Oder du hast einen besseren Humanizer benutzt.

Der Vergleich ist nicht so weit hergeholt, wie er klingen mag. Die Methoden der mittelalterlichen Hexenjäger waren zumindest ehrlich in ihrer Willkür. Die modernen KI-Detektoren tarnen sich als Wissenschaft, obwohl sie auf Grundlagen stehen, die so wackelig sind wie ein Kartenhaus im Gewittersturm.

Ja, es gibt KI-generierte Texte. Das ist keine Verschwörungstheorie, keine Einbildung besorgter Lehrkräfte. Die Technologie existiert, sie wird genutzt, und sie ist verdammt gut geworden. GPT-4, Claude 3.5 Sonnet, Gemini – diese Systeme produzieren Texte, die von menschlicher Sprache kaum noch zu unterscheiden sind. Aber genau hier liegt das Problem: Wenn etwas kaum noch unterscheidbar ist, wie verlässlich kann dann eine Maschine sein, die behauptet, es trotzdem zu erkennen?

Die Illusion der Präzision

Die Hersteller von KI-Detektoren werfen mit Zahlen um sich wie Börsenhändler mit Millionen. 99 Prozent Genauigkeit! Unter 1 Prozent Falsch-Positiv-Rate! Klingt beeindruckend. Klingt nach Wissenschaft. Ist es aber nicht.

GPTZero, Winston AI, Originality.ai – sie alle basieren auf demselben Grundprinzip: Sie messen, wie «glatt» ein Text ist. Wie vorhersehbar. Wie statistisch durchschnittlich. Die Theorie dahinter ist nicht dumm: KI-Modelle sind darauf trainiert, das wahrscheinlichste nächste Wort zu wählen. Das macht ihre Texte vorhersehbar, in der Fachsprache: Sie haben eine niedrige Perplexität. Menschliche Texte hingegen sind chaotischer, sprunghafter, überraschender. Sie haben eine höhere Perplexität und Burstiness.

So weit die Theorie. In der Praxis funktioniert das ungefähr so gut wie die Vorhersage, dass es im April regnen wird. Stimmt statistisch. Hilft dir aber nichts, wenn du wissen willst, ob du am 23. April einen Regenschirm brauchst.

Das Problem ist fundamental: Je besser die KI-Modelle werden, desto mehr nähern sie sich der menschlichen Sprachverteilung an. Und wenn diese Verteilungen irgendwann nicht mehr unterscheidbar sind – was passiert dann? Dann wird die Detektion informationstheoretisch unmöglich. Nicht schwierig. Nicht ungenau. Unmöglich.

Wir bewegen uns schnurstracks auf diesen Punkt zu.

Die Diskriminierungsmaschine

Aber es kommt noch schlimmer. Eine Studie der Stanford University hat gezeigt, dass über 60 Prozent der TOEFL-Aufsätze – geschrieben von Menschen, die Englisch als Fremdsprache lernen – von KI-Detektoren als maschinengeneriert markiert wurden.

Denk mal darüber nach. Mehr als die Hälfte.

Der Grund ist so simpel wie perfide: Menschen, die eine Sprache lernen, haben einen begrenzten Wortschatz. Sie nutzen einfachere Satzstrukturen. Ihre Texte sind vorhersehbarer, glatter, weniger komplex. Genau wie KI-Texte. Für den Detektor sind sie statistisch nicht unterscheidbar.

Das bedeutet: Wenn du kein Muttersprachler bist, wenn du formales Deutsch schreibst, wenn du nicht die linguistische Vielfalt eines Thomas Mann hast – dann bist du verdächtig. Nicht weil du KI benutzt hast. Sondern weil dein Deutsch zu «normal» ist.

Die Ironie ist kaum zu übersehen: Wir haben Tools entwickelt, die systematisch diejenigen diskriminieren, die am meisten Mühe in ihre Texte stecken müssen. Ausländische Studierende, Menschen mit Lernschwierigkeiten, alle, die sich nicht im muttersprachlichen Luxus suhlen können, kreative Sprachsprünge zu machen.

Die Grammarly-Falle

Und dann ist da noch das, was ich den «Grammarly-Widerspruch» nenne. Stell dir vor, du bist ein gewissenhafter Mensch. Du schreibst deinen Text, dann lässt du ihn durch Grammarly laufen. Oder DeepL Write. Oder die Word-Rechtschreibprüfung. All diese Tools glätten deinen Text. Sie entfernen die Ecken und Kanten, korrigieren die Fehler, standardisieren die Formulierungen.

Ergebnis? Dein Text wird statistisch glatter. Vorhersehbarer. Weniger chaotisch. Und der KI-Detektor schlägt an.

Originality.ai ist dafür berüchtigt. Das Tool markiert regelmäßig Texte als KI-generiert, die lediglich professionell lektoriert wurden. Die absurde Konsequenz: Korrektes, fehlerfreies Deutsch wird verdächtig. Fehlerhaftes Deutsch gilt als authentisch.

Wir haben ein System geschaffen, in dem Inkompetenz als Echtheitsbeweis gilt.

Das Wettrüsten

Natürlich gibt es eine Gegenindustrie. Für jede Detektionstechnologie entsteht zeitnah eine Umgehungsstrategie. Der Markt für sogenannte «Humanizer» boomt. Tools wie Undetectable.ai oder StealthGPT versprechen, KI-Texte so umzuschreiben, dass sie menschlicher wirken. Sie erhöhen künstlich die Perplexität, bauen Varianz in die Satzlänge ein, fügen absichtlich kleine Unregelmäßigkeiten ein.

Das funktioniert erstaunlich gut. Studien zeigen, dass ein rekursiv paraphrasierter KI-Text selbst die besten Detektoren auf Zufallsniveau drücken kann. Mit anderen Worten: Die Detektoren sind nicht besser als eine Münze zu werfen.

Die einzigen, die von diesem Wettrüsten profitieren, sind die Anbieter beider Seiten. Die einen verkaufen dir das Gift, die anderen das Gegengift. Und du sitzt in der Mitte und fragst dich, ob deine Hausarbeit jetzt verdächtig aussieht, weil du zu viele Kommas gesetzt hast.

Disney und die Akzeptanz des Unvermeidlichen

Während wir also noch diskutieren, ob und wie man KI-Texte erkennen kann, haben die großen Player längst verstanden, worum es wirklich geht. Der Deal zwischen Disney und OpenAI ist symptomatisch: Disney hat erkannt, dass es sinnvoller ist, an der KI zu verdienen, als sie zu verteufeln.

Das ist keine moralische Kapitulation. Das ist Pragmatismus. Die KI ist nicht aufzuhalten. Sie wird nicht verschwinden, weil ein paar Detektoren behaupten, sie erkennen zu können. Was wir brauchen, ist keine bessere Hexenprobe. Wir brauchen eine andere Frage.

Die falsche Frage

Die Frage ist nicht: Wurde dieser Text von einer KI geschrieben?

Die Frage muss sein: Ist dieser Text gut?

Ist er präzise, ist er originell, ist er durchdacht, hat er einen Mehrwert? Spielt es wirklich eine Rolle, ob jemand ein Tool benutzt hat, um Gedanken zu strukturieren, Grammatik zu korrigieren, Formulierungen zu verbessern? Wir haben jahrhundertelang Wörterbücher, Enzyklopädien, Ghostwriter akzeptiert. Warum ist ein algorithmischer Assistent plötzlich Betrug?

Der Geschmack von Menschen ist unterschiedlich. Ein Text kann technisch perfekt und dennoch langweilig sein. Ein anderer kann voller Fehler stecken und trotzdem brillant. Die Obsession, die Urheberschaft zu beweisen, lenkt uns vom Wesentlichen ab: der Qualität des Inhalts.

Natürlich gibt es Grenzen. Ein Student, der eine komplette Hausarbeit von ChatGPT schreiben lässt, ohne sie zu verstehen, hat nichts gelernt. Aber das Problem ist nicht das Tool. Das Problem ist die fehlende Kompetenz. Und die lässt sich nicht durch einen Detektor messen. Die zeigt sich im Gespräch, in der mündlichen Prüfung, in der Fähigkeit, über den Text zu reflektieren.

Was die Universitäten bereits verstanden haben

Die Humboldt-Universität Berlin, die Universität Wien, die TU München – sie alle bewegen sich weg von der Detektion. Stattdessen fordern sie Transparenz: Erkläre, welche Tools du genutzt hast. Zeige, wie du sie eingesetzt hast. Reflektiere über den Prozess.

Das ist der richtige Ansatz. Nicht Kontrolle, sondern Kompetenz. Nicht Verbote, sondern Verantwortung.

Detektoren, so die einhellige Meinung dieser Institutionen, sind unzuverlässig. Sie können als Indikator dienen, als Rauchmelder, der weitere Prüfung nahelegt. Aber niemals als Richter. Ein positiver Befund darf nicht die alleinige Grundlage für eine Verurteilung sein.

Das ist nicht nur akademische Vorsicht. Das ist juristische Notwendigkeit. Die Beweislast kann nicht umgekehrt werden. Ein Student kann nicht beweisen, dass er etwas nicht getan hat. Das ist der berühmte Negativbeweis – und der ist unmöglich.

Die Zukunft liegt in der Provenienz

Die Zukunft der Authentifizierung liegt nicht in besseren Detektoren. Sie liegt in kryptografischen Signaturen, in Standards wie C2PA, in Watermarking-Technologien, die bereits bei der Erstellung eines Textes greifen. Google SynthID ist ein Schritt in diese Richtung. Der EU AI Act ein weiterer.

Wenn KI-Modelle verpflichtet werden, ihre Outputs zu markieren, brauchen wir keine forensische Analyse mehr. Dann wissen wir ab Werk, was maschinell ist und was nicht. Transparenz statt Hexenjagd.

Bis dahin müssen wir mit der Unsicherheit leben. Und das ist vielleicht die wichtigste Lektion: Akzeptiere die Ambiguität. Ein Text ist nicht binär. Er ist nicht entweder rein menschlich oder rein maschinell. Die meisten Texte sind Hybride. Und das ist okay.

Eins weiß ich

Die Tools zur KI-Detektion sind nicht per se schlecht. Sie basieren auf soliden statistischen Prinzipien. Aber sie sind fragil. Sie sind fehleranfällig. Sie diskriminieren. Und sie werden zunehmend obsolet, je besser die KI wird.

Wer sie einsetzt, sollte das mit dem nötigen Bewusstsein tun. Sie sind keine Wahrheitsmaschinen. Sie sind Wahrscheinlichkeitsrechner. Und Wahrscheinlichkeit ist kein Beweis.

Die mittelalterlichen Hexenjäger waren überzeugt, dass ihre Methoden funktionierten. Die Wasserprobe war für sie Wissenschaft. Heute wissen wir es besser. Vielleicht sollten wir aus dieser Geschichte lernen, bevor wir die nächste Generation von Studierenden auf den digitalen Scheiterhaufen schicken.

Die KI ist da. Sie wird bleiben. Die Frage ist nicht, wie wir sie erkennen, sondern wie wir mit ihr umgehen. Und das beginnt damit, dass wir aufhören, nach Hexen zu suchen.

Für die Recherche zu diesem Text wurde Google Gemini Deep Research und LeChat von Mistral eingesetzt. Der Text wurde menschlich geschrieben und in Teilen von der KI überarbeitet. Das Bild ist auf der Basis eines eigen entwickelten Stilprompts entstanden.